- ホーム

- データ活用塾

- ビッグデータ活用講座

- 始めに ビッグデータとは

始めに ビッグデータとは

ビッグデータの歴史

最近、ビッグデータが話題になっていますが、その実態を知る人は多くありません。

大多数の人は、データ量が非常に多く、それを解析すると何らかの有益な情報を得られるデータくらいにしか考えていないのではないでしょうか。

確かにデータ量が非常に多いデータは、ビッグデータではありますが、そこから有益な情報が得られるかどうかは疑問です。

そこで、最初にビッグデータとはどのようなものかを紐解いていきます。

最近、ビッグデータが話題になっていますが、その実態を知る人は多くありません。

大多数の人は、データ量が非常に多く、それを解析すると何らかの有益な情報を得られるデータくらいにしか考えていないのではないでしょうか。

確かにデータ量が非常に多いデータは、ビッグデータではありますが、そこから有益な情報が得られるかどうかは疑問です。

そこで、最初にビッグデータとはどのようなものかを紐解いていきます。ビッグデータの利用目的から考えると、そこから有益な情報を得るということが第―に挙げられます。 しかし、有益な情報を得るためには、情報を利活用するための目的が明確になっており、その目的に適合した何種類かのデータが一定量必要になります。

このように、ビッグデータは、「ある目的を持って集められたデータ」であると考えることができます。 しかし、実際にはすでに多方面で多くのデータが蓄積されており、これらのデータから必要な情報を見つけ出すということが求められます。

このため、「ある目的を達成するために必要な情報が含まれるデータ」の集まりがビッグデータと考えることができます。 前者は企業等が調査を行い収集されるデータで、後者は商品別の売上予測を立てるためのPOSデータなどがあります。

また、目的を達成するためには正確な情報が必要であり、そのためには「十分なデータ量」と「十分なデータの種類」が必要となります。

さらに、「正確な情報を得るための処理方式や処理時間の問題」もあります。

ビッグデータの場合、通常の方式では処理できず、新しい方式が登場することも考えられます。

また、目的を達成するためには正確な情報が必要であり、そのためには「十分なデータ量」と「十分なデータの種類」が必要となります。

さらに、「正確な情報を得るための処理方式や処理時間の問題」もあります。

ビッグデータの場合、通常の方式では処理できず、新しい方式が登場することも考えられます。このようなビッグデータを過去から振り返り、今後の方向性を考えてみたいと思います。

世界で初めての本格的ビッグデータ

国を統治するためには、国内の実情を正確に把握する必要があり、そのための調査が行われます。 これは、ローマ帝国時代にも行われており、現在まで続いています。 このような国が目的を持って行った調査により得られる大量データは、ビッグデータと言っても良いでしょう。しかし、データの解析技法から考えると、統計学的な手法を用いた中世以降がビッグデータ時代の幕開けとなります。 特に、人手による解析から、機械を使用した解析が行なわれた1890年のアメリカでの国勢調査は、画期的な出来事です。

アメリカでは、10年ごとに国勢調査(全数調査)を行っています。 1880年に行われた調査では集計に7年かかり、その当時の移民による人口増を考えると1890年の調査の集計には10年以上かかることが予想されていました。

そこで、政府は集計を短縮する方策を公募し、ホレリスが考案したパンチカードと電気作表システムが採用され、集計作業がわずか18ヶ月で終了したのでした。 このホレリスの考案したシステムは、後にパンチカードシステムとして日本の国勢調査でも使われることとなったのです。

この様に、アメリカの1890年国勢調査は、

この様に、アメリカの1890年国勢調査は、・目的を持って集収されたデータ

・データの種類(項目)も多い

・人手では処理できない大量のデータ

・解析技法がある

・短期間で解折できた

の条件が揃ったものであり、現在にも通じる本格的ビッグデータであるのです。

なお、ホレリスの考案したシステム(パンチカードシステム)は、その後他の国の国勢調査でも使用され、日本でも1920年の最初の国勢調査で使用されました。 また、ホレリスがこのシステムのために興した会社がIBMの前身となったのです。

コンピュータとビッグデータ

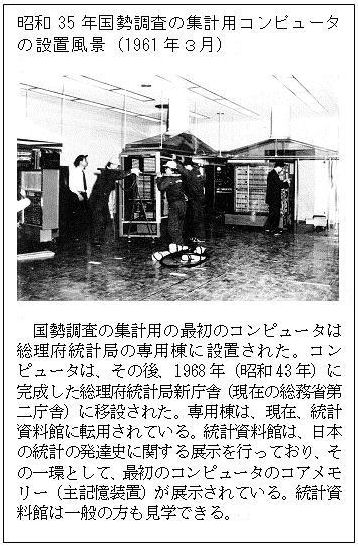

パンチカードシステムは、1890年のアメリカにおける国勢調査以後発展し、大量データの解析には威力を発揮しました。 しかし、同じカードを何度も使用することもあり、人手による操作が必要でした。しかし、1960年代コンピュータが普及し始めると、最初にカードにパンチされたデータを入力すると、その後同じデータのカード入力が必要ないことや、プログラミングによる効率的な集計や柔軟な作表が可能となったことにより、ビッグデータの解析にコンピュータが使用されるようになりました。 日本でも、1961年に総理府統計局に国勢調査の集計用としてコンピュータが導入されました。

1970~1980年代には、民間も含めてコンピュータが本格的に導入し始め、多くの業務でコンピュータが使われ始めました。 それとともに業務で使われるデータも増え始め、総合的にデータを管理するデータベース(DBMS)が出てきました。

BDMSでは、社内業務の目的に沿って構築されてきましたが、企業の意思決定には不十分なところがありました。

そのため、1990~2000年代になると企業の様々なデータを一か所に集めるデータウエアハウスと呼ばれる概念が出現し、データマイニングやOLAPとともに企業の意思決定に使われるようになりました。

これらDBMSやデータウエアハウスで蓄積されたデータもビックデータの一つです。

BDMSでは、社内業務の目的に沿って構築されてきましたが、企業の意思決定には不十分なところがありました。

そのため、1990~2000年代になると企業の様々なデータを一か所に集めるデータウエアハウスと呼ばれる概念が出現し、データマイニングやOLAPとともに企業の意思決定に使われるようになりました。

これらDBMSやデータウエアハウスで蓄積されたデータもビックデータの一つです。1960~2000年には、コンピュータの高性能化と低価格化が進むとともにデータを蓄積するハードディスクの高密度化が進み、データウエアハウスのような大量データの蓄積が一般企業でも可能になりました。 また、ソフトウェアの技術も進み、種々のデータ解析も可能となりました。 しかし、データはある限られた範囲内でしか収集しておらず、データ量については飛躍的な増大には至ってはいません。

ところが、2000年以後インターネットの普及に伴い、個人の様々なデータがネットワークを流れるようになり、蓄積されるデータ量も飛躍的に増大することになりました。 また、企業においても世の中の動向をつかむためインターネットを利用するようになり、データ量の飛躍的増大に拍車をかけることとなりました。

このような多種多様で膨大なデータを処理する技術が発展し、ハードウェアでは、コンピュータの一層の高性能化、特にメモリーのインメモリ化があり、ソフトウェアでは、BIなどの各種分析ツール普及があります。今後は、更に高速で使い易いツールの普及が見込まれます。

しかし、ビッグデータを使いこなしている企業はまだまだ少ないのが実情です。これは「どうしてか」という点については、次の節で考えてみたいと思います。

| ※ビッグデータにまつわる主な出来事 | |

| 紀元前27年 | ローマ帝国が人口や土地を調査 「人口ルネサンス」 |

| 1890年 | アメリカでパンチカードによる国勢調査を実施 7年かかっていた集計が18ケ月で完了 |

| 1920年 | 日本でもパンチカードによる国勢調査を実施 |

| 1961年 | 日本で国勢調査集計用としてコンピュータ導入 |

| 1970年~ | 民間を含めたコンピュータの本格導入 データベース(DBMS)の登場 |

| 1990年~ | データウエアハウス概念の出現 データマイニングやOLAPによる分析 |

| 2000年~ | インターネットの普及と利活用 データ量が飛躍的に増大 |

参考URL

●統計の歴史を振り返る~統計の3つの源流~(総務省 統計局)

https://warp.da.ndl.go.jp/info:ndljp/pid/11509863/www.stat.go.jp/teacher/c2epi1.html

●ビッグデータと国勢調査――その意外な結びつきの話(ダイヤモンド・オンライン)

http://diamond.jp/articles/-/38184

●ビッグデータの理想と現実(国立情報学研究所 佐藤一郎)

http://www.juce.jp/sangakurenkei/event/houkoku/no6_kouen_03.pdf

●統計の歴史を振り返る~統計の3つの源流~(総務省 統計局)

https://warp.da.ndl.go.jp/info:ndljp/pid/11509863/www.stat.go.jp/teacher/c2epi1.html

●ビッグデータと国勢調査――その意外な結びつきの話(ダイヤモンド・オンライン)

http://diamond.jp/articles/-/38184

●ビッグデータの理想と現実(国立情報学研究所 佐藤一郎)

http://www.juce.jp/sangakurenkei/event/houkoku/no6_kouen_03.pdf

ビッグデータの今後

当初、ビッグデータは何らかの目的で集められた解析可能な大量のデータ群でした。 しかし、インターネットの普及にともない様々なデータが多数集積され、近年それら全体をビッグデータと言うようになりました。 そして、ビッグデータの特徴は、2001年にダグ・レイニーが示した、量(volume)・速度(velocity)・多様性(variety)を持つデータであり、この様な特徴を考慮したうえで、分析ツールなどを利用して実際の解析が行われます。

そして、ビッグデータの特徴は、2001年にダグ・レイニーが示した、量(volume)・速度(velocity)・多様性(variety)を持つデータであり、この様な特徴を考慮したうえで、分析ツールなどを利用して実際の解析が行われます。分析ツールについてもユーザインタフェースの良いBI製品が出てきていますが、実際にビッグデータの分析はそれほど行われていません。 これは、分析する人の資質の問題が大きいと思われます。 この資質に関しては、次回で詳しく紹介しますが、少なくとも統計に関する基礎知識や業界に関する知識は必要になります。

このような知識は、AIを利用すると簡単に機械化できる可能性はありますが、業界に関する知識をすべて網羅することは難しく、また多種多様なデータのどれを利用するかも難しいのが実情です。 当面は、ある特定の分野でのAI活用が現実的で、特にある傾向から未来を予測するよりも、データの中の特異点を見つけ出すほうが、より現実的です。 例えば、この特異点を見つけ出すことにより、不正利用などを見つけ出すことが可能になります。

データサイエンスの必要性

データの利活用は、組織にとって良い結果をもたらすだけではなく、組織を利用する人にとっても良い結果をもたらすことは、前節の事例からも理解できたかと思います。では、データの利活用をどの様に実現するかというと、

①ある目的を達成するためのデータを集める

②集められたデータを目的に沿って分析を行う

③その結果に基づいた行動を行う

②集められたデータを目的に沿って分析を行う

③その結果に基づいた行動を行う

ことで実現することができます。

しかし、この行動が正しいかどうかは検証する必要があり、そのために再度①~③を実施します。このサイクルを繰り返すことにより、効果を高めることが可能になります。

では①~③を実施するためには、どの様なスキルが必要なのかを考えてみたいと思います。

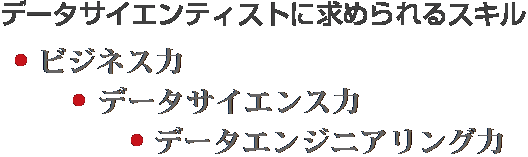

まず①の「ある目的を達成するためのデータを集め」において「ある目的」とありますが、この目的は企業などの課題を明確にし、その課題を解決することが、「ある目的」であるといえます。この様に、企業を取り巻く環境を理解し課題を見つけ整理する「ビジネス力」が必要です。

次に、②の「集められたデータを目的に沿って分析を行う」では、集められたデータを分析するスキルも必要になります。データ分析を行うためには、情報処理や統計学などの情報科学系の知識を理解し使いこなせる「データサイエンス力」が必要です。

更に、③の「その結果に基づいた行動を行う」においては、データサイエンス力を実際のビジネスで使えるようにする「データエンジニアリング力」が必要となります。

この様なスキルを持った技術者は「データサイエンティスト」と呼ばれ、現在広く求められています。

データサイエンティストを育てていくためには、3つの力を養成する必要がありますが、「ビジネス力」については、組織に所属し、ある程度活動して入れば、それなりに身についていくと思われます。

「データサイエンス力」についても、パソコンを使いこなせるなら情報処理についてはある程度の力があると思われます。統計学については、少々勉強が必要ですが、いきなりすべてを理解するのは難しいので、最初にExcelのピボットテーブルを利用して行うことができる統計処理をマスターし、理解できるようにするとよいでしょう。

最後に「データエンジニアリング力」ですが、これは実際に分析を行いながら身に着けていくのが一番良い方法です。具体的には、実際の課題を解決するための目的を設定し、そのためのデータ収集を行い、実際の分析を単純集計・クロス集計をExcelのピボットテーブルを使用して繰り返し行うことにより問題点を見つけ出すことを行えばよいでしょう。これについては次回、詳しく説明いたします。